第 1 页 / 共 7 页

考试重点_第1页_学霸英雄_www.xuebayingxiong.com.png)

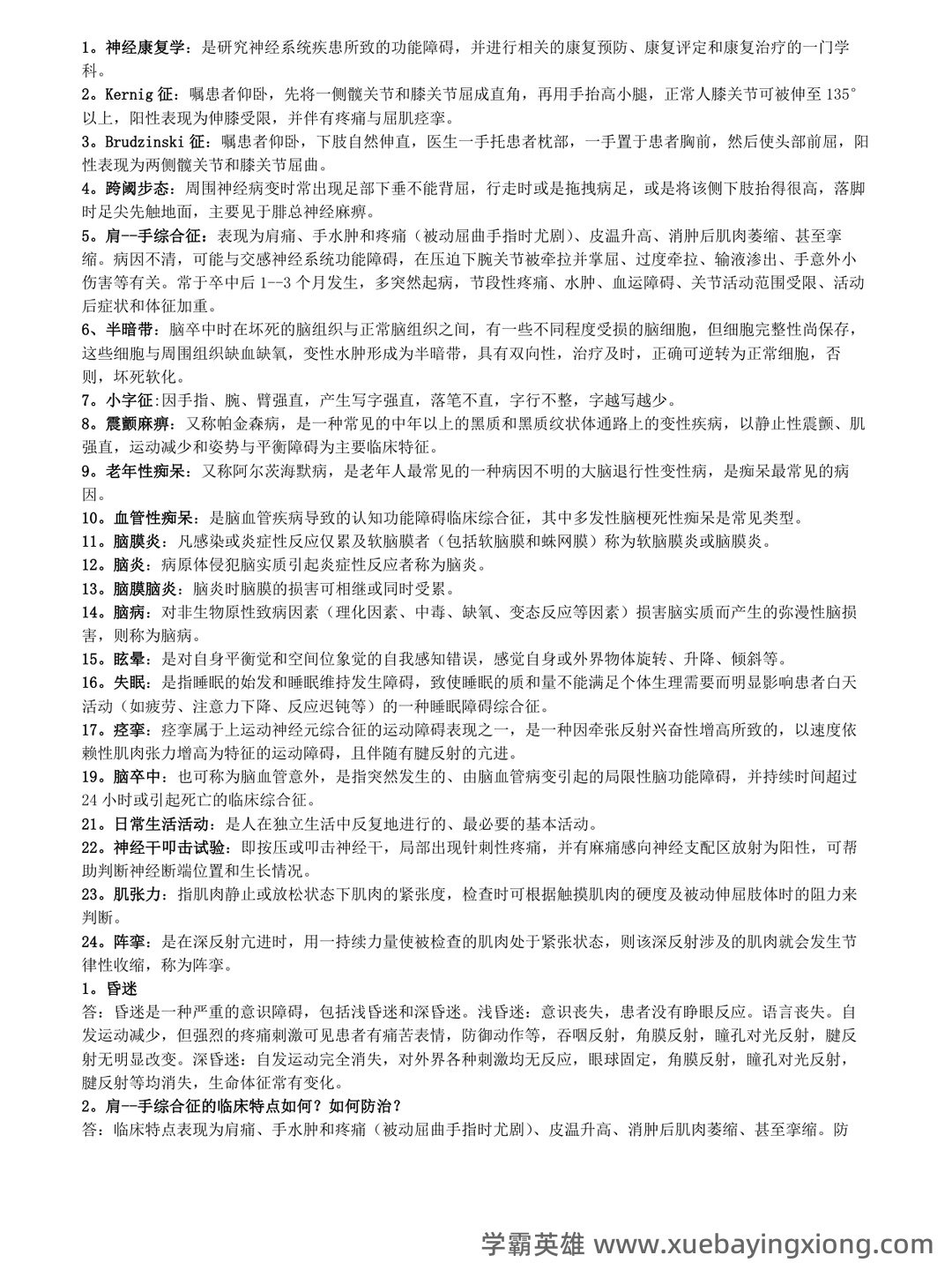

第 2 页 / 共 7 页

考试重点_第2页_学霸英雄_www.xuebayingxiong.com.png)

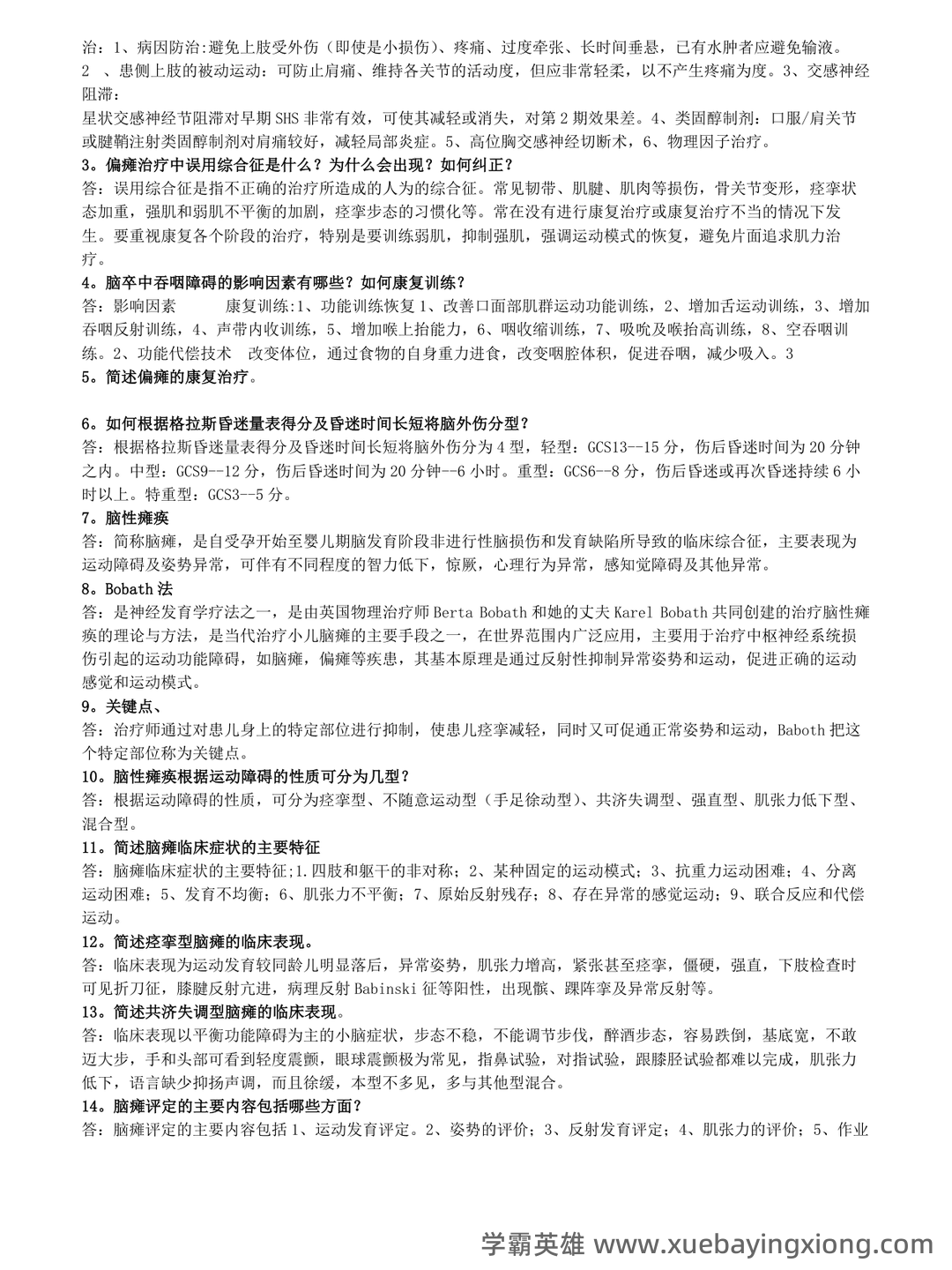

第 3 页 / 共 7 页

第 4 页 / 共 7 页

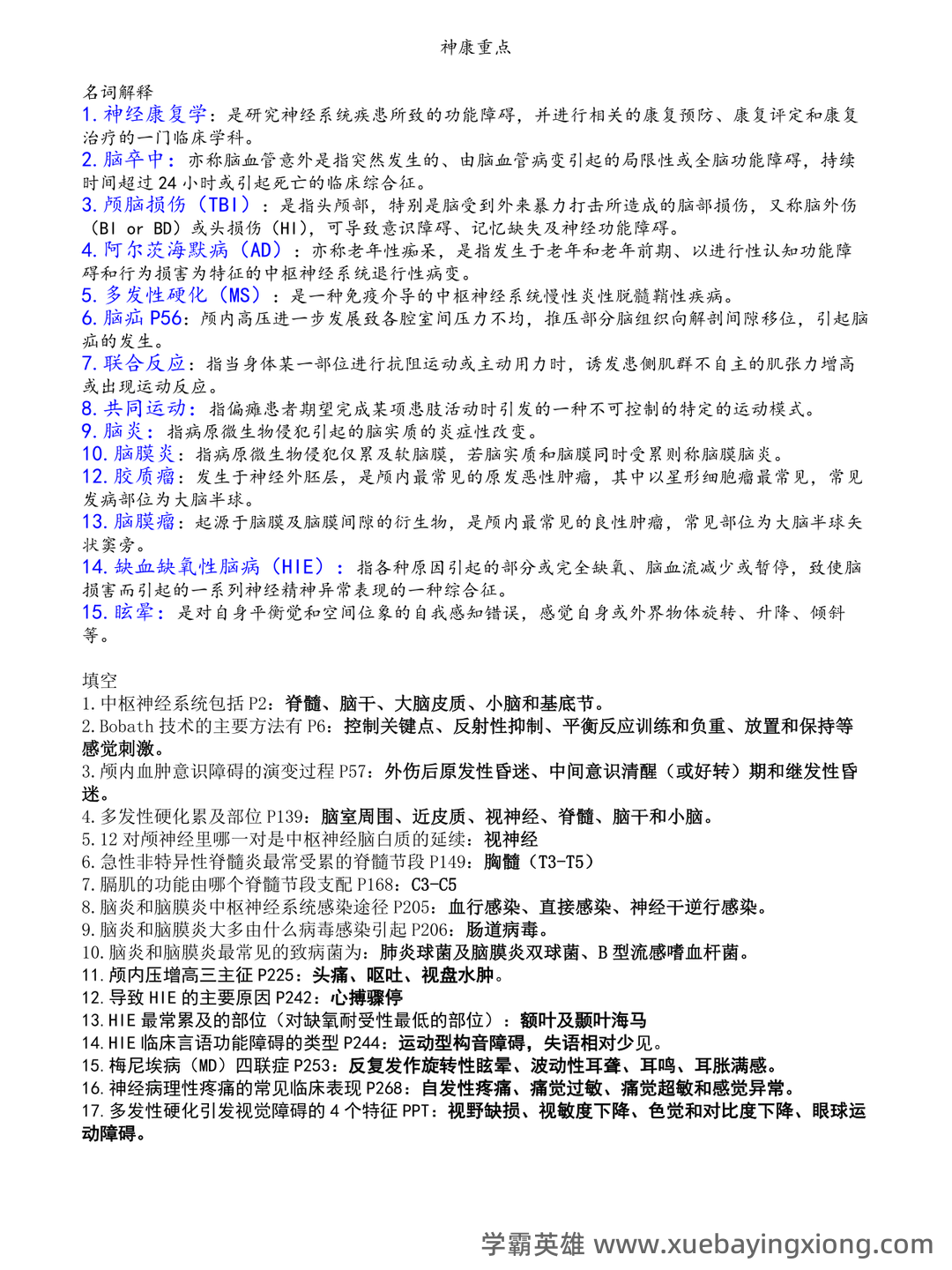

第 5 页 / 共 7 页

第 6 页 / 共 7 页

第 7 页 / 共 7 页

神经康复学-ReLu函数

神经康复学-ReLu函数 神经康复学,一个充满希望和挑战的领域,致力于帮助那些因脑卒中、脊髓损伤等神经系统疾病患者,重拾生活能力。在这个过程中,技术进步扮演着至关重要的角色,而深度学习中的ReLu函数,正悄然改变着康复训练的策略。 ReLu(Rectified Linear Unit)函数,最初在深度学习领域崭露头角,它的出现打破了传统激活函数Sigmoid的梯度消失问题。简单来说,ReLu函数规定如果输入值为正,则输出等于输入;如果输入值为负,则输出为零。这使得神经元在训练过程中更容易激活,从而加速神经系统的恢复进程。 在神经康复训练中,ReLu函数的应用并非直接使用,而是通过模拟其原理来构建更有效的康复模型。例如,康复训练可以被视为一种“学习”过程,患者通过反复的尝试和纠正,逐渐调整自身的神经通路,提高运动功能。 就像ReLu函数,只有积极的“输入”才能产生有意义的“输出”。 具体来说,康复训练的“输入”可以是各种刺激,如电刺激、运动引导、认知训练等。通过精心设计的训练方案,引导患者的神经元建立新的连接,就像ReLu函数中的正向输入。 关键在于,康复训练需要持续的反馈和调整,才能实现最佳的神经可塑性。 总而言之,ReLu函数虽然源于机器学习,但其核心思想——积极正向驱动,对于神经康复学的应用具有启发性意义。它提醒我们,神经康复的最终目标,并非简单地恢复原有功能,而是通过系统的、有针对性的训练,激活患者潜在的神经可塑性,最终实现患者的康复。

展开

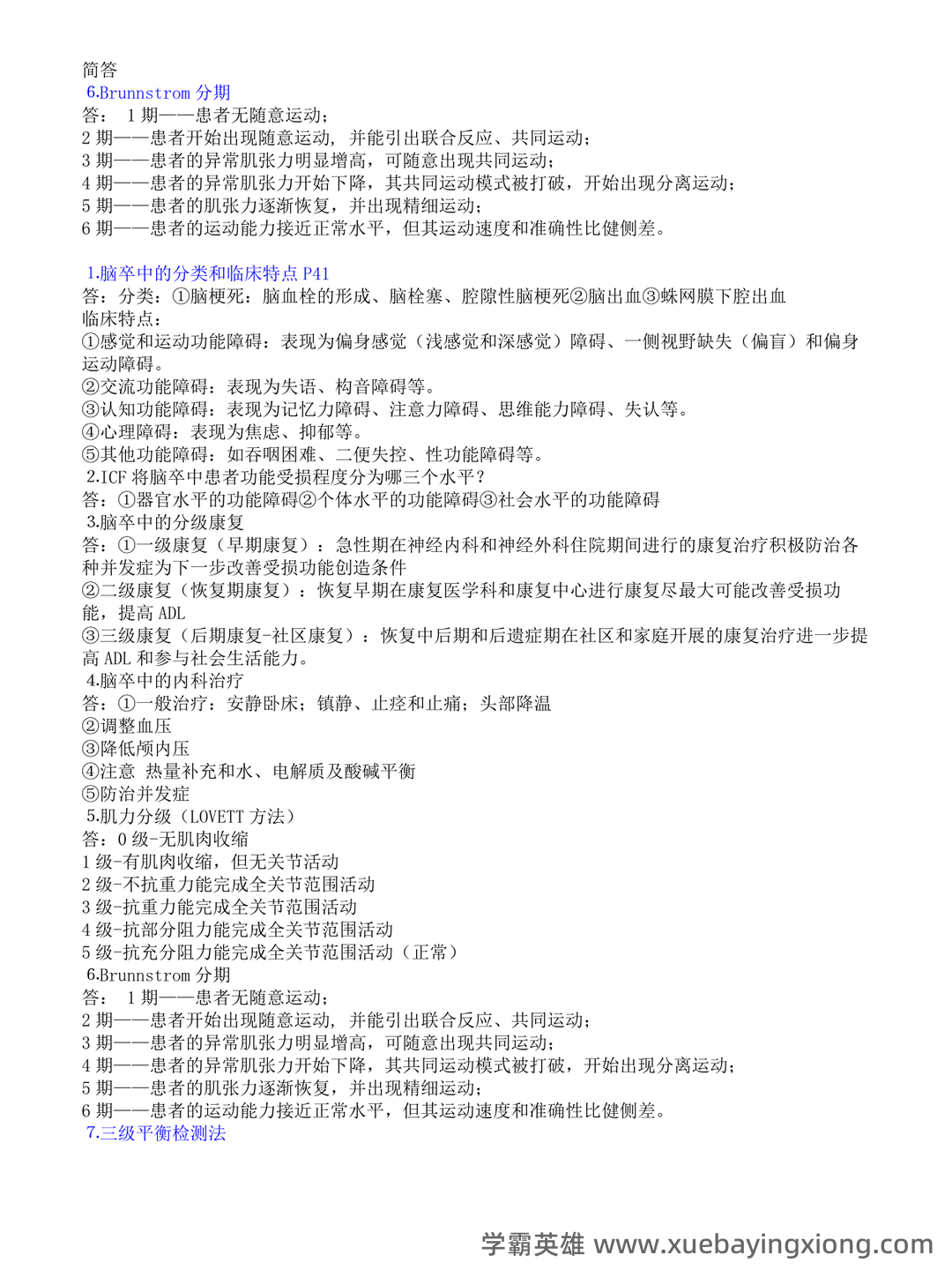

神经康复学

2025-07-30

5次阅读

资料获取方式

温馨提示:登录学霸英雄官网后可获取更多大学生必备科目和考证等复习备考资料!